为了增强大型语言模型(LLM)的推理能力,谷歌 Deepmind 和南加州大学的研究人员提出了一种新的“自我发现”提示框架。

该方法今天早上在 arXiV 和 Hugging Face 上发布,超越了法学硕士使用的现有提示技术,并且被发现能够提高已知模型的性能,包括 OpenAI 的 GPT-4 和 Google 的 PaLM 2。

研究人员在论文中写道:“与 Chain of Thought (CoT) 相比,自我发现大大提高了 GPT-4 和 PaLM 2 在具有挑战性的推理基准(例如 BigBench-Hard、扎根代理推理和 MATH)上的性能,提高了 32%” 。

该框架围绕法学硕士自我发现任务内在推理结构来解决问题。

这些模型着眼于多个原子推理模块,例如批判性思维和分步思维,并将它们组合成明确的推理结构,供法学硕士在解码过程中遵循。

更有趣的是,这种方法的推理计算量减少了 10 到 40 倍,这对企业来说非常有用。

自我发现独特的结构

法学硕士已经发展到能够处理众多任务,这要归功于他们遵循指示、推理和产生连贯反应的能力。

为了实现这一目标,由 Transformer 架构提供支持的模型使用了各种提示技术,这些技术受到人类如何推理和解决问题的认知理论的启发。

这包括少样本和零样本思维链,其灵感来自于我们如何一步步解决问题,分解提示我们如何将问题分解为多个子问题,以及后退提示我们如何反思问题。确定一般原则的任务性质。

虽然所有这些方法(尤其是思想链方法)都可以完成工作,但它们都是通过对如何处理给定任务做出隐含的先验假设来起作用的。

研究人员认为,这种方法可能不是最好的,因为每项任务都有独特的内在结构,并且一种特定的技术可能比另一种更能解决问题。

通过最新的研究,Deepmind 和南加州大学的研究人员提出了一个通用的提示框架,可以自我发现这种独特的底层结构,从而为任务选择正确的推理技术,同时又保持高效。

“自我发现的灵感来自于人类如何在内部设计解决问题的推理程序。

从一组用自然语言描述的原子推理模块,如“分解为子任务”和“批判性思维”、法学硕士和没有标签的任务示例,它组成了任务固有的连贯推理结构(阶段1)和然后使用发现的结构解决任务实例(阶段2)。

第 1 阶段在任务级别运行,并使用三个操作来指导 LLM 生成任务的推理结构。

在第二阶段,在最终解码过程中,法学硕士只需遵循自我发现的结构即可得出最终答案,”研究人员解释道。

已知法学硕士的显着性能改进

为了了解新方法的工作原理,研究人员使用多种模型(包括 GPT-4 和 PaLM 2-L)在 25 项推理任务(包括 Big-Bench Hard、Thinking for Doing 和 Math)上对其进行了测试。

在 25 项任务中的 21 项中,自我发现的表现优于链式推理和其他技术,性能提升高达 32%。

研究人员还发现,它在效率方面表现更好,所需的推理计算量减少了 10 到 40 倍。

根据论文中分享的数据,在使用 GPT-4 时,自我发现方法在 Big-Bench Hard、Thinking for Doing 和 Math 任务中的准确率分别为 81%、85% 和 73%。

然而,当使用思维链时,结果分别下降到 75%、52% 和 71%。

当与计划和解决方法进行比较时,发现了几乎相似的差距。

另一方面,PaLM 2-L 在这三项任务中取得了 67%、69% 和 50.5% 的准确率。

这低于 GPT-4,但仍然比使用思维链(60%、40% 和 42%)和计划与解决(61%、42% 和 49%)方法所取得的成果要好得多。

改进推理是人工智能成功的关键

虽然自我发现激励框架的想法刚刚被提出,但它有潜力突破问题解决的界限,让法学硕士能够轻松解决具有挑战性的问题——最终朝着通用智能的目标迈进。

值得注意的是,研究人员进行的可转移性研究表明,所组成的推理结构普遍适用于模型家族,并且与人类推理模式具有共性。

该团队补充道:“展望未来,我们很高兴能够探索更多关于法学硕士结构化推理的内容,以突破问题解决的界限并发现人类与人工智能协作的潜力。”

清崎发表此番言论之前,斯科特·梅尔克最近采访了以大局分析而闻名的帕尔。 帕尔表示,从历史上看,比特币和其他加密货币等投资往往在美国总统大选年的最后一个季度表现良好。“选举年的最后一个季度是所有资产真正的香蕉区,”帕尔说。...

清崎发表此番言论之前,斯科特·梅尔克最近采访了以大局分析而闻名的帕尔。 帕尔表示,从历史上看,比特币和其他加密货币等投资往往在美国总统大选年的最后一个季度表现良好。“选举年的最后一个季度是所有资产真正的香蕉区,”帕尔说。...

人工智能 AI 有人热情膜拜,有人畏惧如虎,AI 的发展已经进入高层面的快车道,技术更新迭代日新夜异,技术无罪也无善恶,曾经科幻未来的人机交流,共生共存如今在我们的脑海中已经有了轮廓的意识感想,科技是第一生产力,无人能脱...

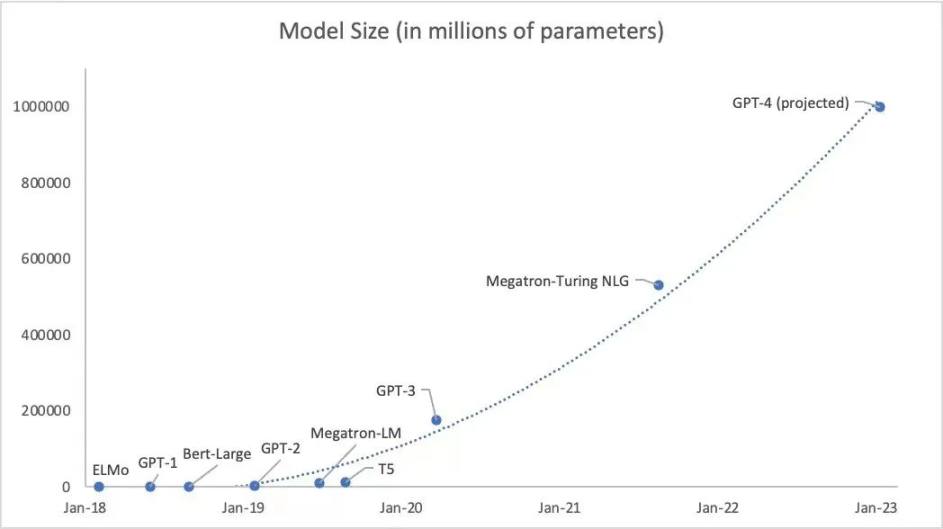

原文来源:阿法兔研究笔记原文作者:阿法兔What GPT-4 has to offer that GPT-3 didn’tGPT-4 Will Have 100 Trillion Parameters — 50 0x t...